Doktor nauk technicznych w dziedzinie fizyki cieplnej Instytutu Problemów Inżynierii Mechanicznej Narodowej Akademii Nauk Ukrainy im. A. Pidhornego. Jej zainteresowania naukowe koncentrują się na: analizie biznesowej i inteligencji, projektowaniu baz danych, analizie domeny danych, rozwoju systemów informacji wywiadowczej, e-learningu. Jest autorką wielu prac naukowych i raportów badawczych w takich dziedzinach jak: informatyka, modelowanie matematyczne, e-learning.

Czy neuromorficzne procesory odwzorują potencjał ludzkiego mózgu w najbliższej przyszłości?

1. Historia rozwoju inżynierii neuromorficznej

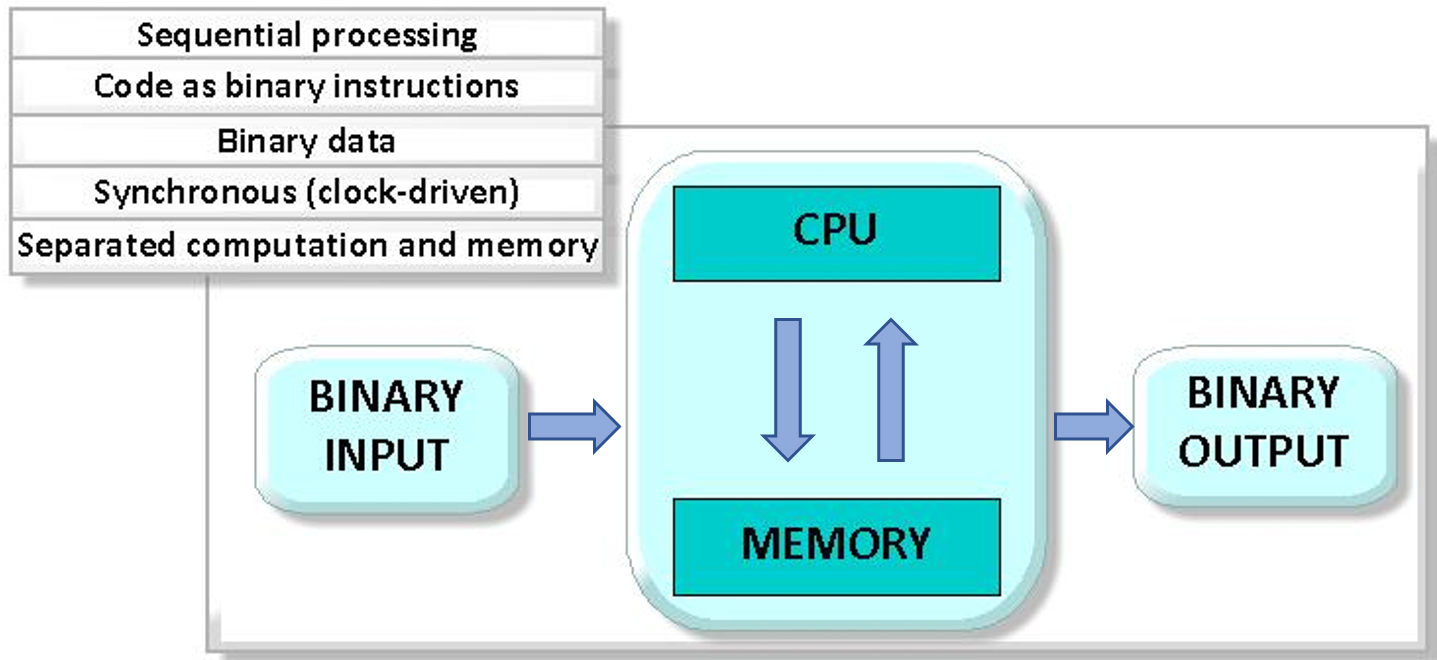

Idea inżynierii neuromorficznej jest ściśle związana z rozwojem urządzeń procesorowych i architektur obliczeniowych. Każdy nowoczesny komputer, tablet i smartfon posiada procesor – uniwersalne urządzenie przeznaczone do wykonywania różnorodnych programów. Podstawowymi elementami architektury procesora są układ arytmetyczno-logiczny, rejestry pamięci, jednostka sterująca, pamięć cache oraz magistrale. Podstawowymi komponentami procesorów graficznych i centralnych są tranzystory – elektroniczne przełączniki, które umożliwiają przesyłanie sygnałów binarnych (0 i 1). Zasady działania tradycyjnych procesorów zostały ustalone już w latach 40. XX wieku i od tego czasu nie uległy większym zmianom. Klasycznym modelem architektury komputerowej jest architektura von Neumanna (ang. von Neumann architecture), która stanowi zasadę budowy komputera uniwersalnego. Zgodnie z nią rozkazy i dane są przechowywane w tej samej pamięci w postaci kodu binarnego, a procesor sekwencyjnie pobiera rozkazy i dane z pamięci, przetwarza je i wykonuje zadania.

Obraz procesora neuromorficznego wygenerowany w DALL·E 3

Architektura von Neumanna

Architektura von Neumanna została nazwana na cześć Johna von Neumanna, matematyka i fizyka, który opracował znaczące prace z zakresu teorii komputerów, dotyczące organizacji logicznej komputerów, problemów funkcjonowania pamięci oraz rozwiązań inżynieryjnych, stanowiących podstawy budowy komputerów i systemów elektronicznych. Termin «architektura von Neumanna» został oficjalnie użyty latem 1945 roku, kiedy J. von Neumann przedstawił wstępny raport dotyczący projektu EDVAC (Electronic Discrete Variable Automatic Computer), jednego z pierwszych komputerów elektronicznych. Koncepcja ta spotkała się z pozytywnym odbiorem w środowisku naukowym i została nazwana na cześć jej autora.

Przez długi czas procesory mogły wykonywać tylko jedną operację na cykl, lecz w latach 70. i 80. XX wieku nastąpił przełom technologiczny – systemy operacyjne komputerów osobistych zaczęły obsługiwać wielozadaniowość. Zdolność do wykonywania kilku programów jednocześnie na jednym procesorze osiągnięto poprzez alokację zasobów: kilka cykli lub taktów przydzielano jednemu programowi, następnie zasoby były przydzielane kolejnemu programowi, a potem kolejnym. Koncepcja wielozadaniowości znacząco wpłynęła na rozwój technologii procesorów, a w latach 90. pojawiły się pierwsze procesory wielordzeniowe, zdolne do równoległego przetwarzania kilku strumieni danych oraz bardziej efektywnej dystrybucji zasobów.

Obliczenia standardowe i równoległe

Dalsza poprawa wydajności procesorów wynikała ze zmniejszenia rozmiaru tranzystorów, co pozwoliło na umieszczenie ich większej liczby na jednym chipie, a tym samym poprawiło szybkość przetwarzania danych oraz efektywność energetyczną procesora. Gdy na początku XXI wieku osiągnięto fizyczną granicę miniaturyzacji tranzystorów, pojawił się problem związany z dalszym zmniejszaniem rozmiaru procesorów na krzemie, ponieważ materiał ten wkrótce osiągnie swoje granice technologiczne. Przejście do procesów technologicznych o rozmiarze mniejszym niż 5 nm napotyka trudności związane z upływem prądu, zjawiskami kwantowymi oraz zwiększonym rozpraszaniem ciepła. Wyzwania te skłoniły do poszukiwania nowych materiałów i architektur, takich jak struktury 3D, nanorurki węglowe, obliczenia kwantowe oraz neuromorficzne.

Dyscyplina, której celem jest przynajmniej częściowe odtworzenie struktury ludzkiego mózgu w postaci obwodów elektronicznych, nosi nazwę «inżynieria neuromorficzna». Termin ten oznacza tworzenie inteligentnych, autonomicznych systemów działających bez potrzeby synchronizacji. Koncepcja «obliczeń neuromorficznych» została po raz pierwszy zaproponowana w latach 80. przez Carvera Meada, profesora California Institute of Technology. C. Mead zaproponował sposób wykorzystania obwodów analogowych do naśladowania działania neuronów i synaps w mózgu. W 1989 roku opublikował książkę «Analog VLSI and Neural Systems», w której przedstawił pomysły na budowę systemów obliczeniowych opartych na biologicznych sieciach neuronowych.

Koncepcja procesorów neuromorficznych jest ściśle związana z teorią sieci neuronowych oraz neurobiologią. Rozwój idei tworzenia sieci neuronowych rozpoczął się w latach 40. i 50., gdy badacze zainteresowali się opracowaniem maszyny zdolnej do naśladowania funkcji ludzkiego mózgu. W 1943 roku Warren McCulloch i Walter Pitts zaproponowali matematyczny model sztucznego neuronu, wykazując, że sieć takich neuronów może wykonywać operacje numeryczne i logiczne. Pod koniec lat 50. Frank Rosenblatt zaprezentował elektroniczne urządzenie – perceptron. To właśnie perceptron można uznać za pierwszą praktyczną implementację sieci neuronowej. Od tego momentu zainteresowanie sieciami neuronowymi zaczęło gwałtownie rosnąć, jednak ich efektywna implementacja wymagała opracowania alternatywnych architektur obliczeniowych, bardziej przystosowanych do działania w warunkach przetwarzania dużych ilości danych i nieustrukturyzowanych informacji. Poszukiwania rozwiązań doprowadziły do koncepcji stworzenia struktury logicznej nowego typu procesorów, które mogłyby odwzorowywać budowę mózgu organizmu żywego, gdzie sygnały (impulsy nerwowe) przekazywane są za pośrednictwem neuronów – miniaturowych elementów wykonawczych połączonych ogromną liczbą synaps, czyli połączeń sygnalizacyjnych.

Od lat 90. XX wieku teoretyczne koncepcje inżynierii neuromorficznej zaczęły być przekształcane w fizyczne systemy, które naśladują architekturę oraz funkcjonowanie ludzkiego mózgu, przetwarzając dane równolegle i asynchronicznie. W 1992 roku programiści z IBM zaprezentowali pierwszy prototyp układu Synapse Chip, który modelował biologiczną sieć neuronową.

W 1997 roku Hugo de Garis oraz jego zespół z ATR Laboratories w Japonii rozpoczęli prace nad urządzeniem o nazwie CAM-Brain Machine. Projekt ten miał na celu stworzenie dużego zestawu „kostek sieci neuronowej”, które modelowałyby działanie sztucznego mózgu.

W 2009 roku Uniwersytet Stanforda, pod kierownictwem Kwabena Boahena, opracował platformę sprzętową i programową o nazwie Neurogrid, zaprojektowaną do energooszczędnego modelowania funkcji ludzkiego mózgu z szybkim przetwarzaniem danych. Obecnie system ten jest wykorzystywany do eksperymentalnego modelowania i wizualizacji.

W 2011 roku rozpoczęto projekt BrainScaleS, który jest częścią szeroko zakrojonej inicjatywy Unii Europejskiej Human Brain Project (HBP), mającej na celu rozwój neuronauki oraz informatyki inspirowanej strukturą mózgu. BrainScaleS, opracowany na Uniwersytecie w Heidelbergu (Niemcy) pod kierunkiem profesorów Johannesa Schemmela i Karlheinza Meiera, łączy technologie analogowe i cyfrowe, umożliwiając przyspieszone symulacje sieci neuronowych w czasie rzeczywistym.

W 2014 roku IBM zaprezentował system neuromorficzny TrueNorth, którego procesor naśladuje działanie miliona neuronów oraz 256 milionów synaps, przy minimalnym zużyciu energii. TrueNorth, opracowany pod kierownictwem Dharmendry Modha, wykazał wysoką skuteczność w zadaniach rozpoznawania wzorców, przetwarzania sensorycznego oraz w innych złożonych aplikacjach.

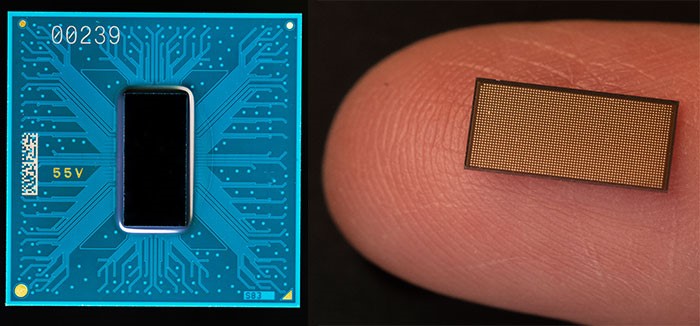

Rozpoczęty w 2005 roku projekt Spiking Neural Network Architecture (SpiNNaker) został zakończony w 2018 roku. SpiNNaker to system neuromorficzny wyposażony w milion rdzeni procesora, zaprojektowany do symulacji pulsujących sieci neuronowych (Spiking Neural Networks) w czasie rzeczywistym. Został on zaprojektowany z myślą o skalowalności oraz efektywności energetycznej, wykorzystując inteligentne techniki komunikacji.

W 2018 roku Intel Labs zaprezentowało Loihi, neuromorficzny procesor zbudowany w technologii Intel FinFET, wykorzystujący proces technologiczny 14 nm. Loihi symuluje działanie 131 072 sztucznych neuronów, połączonych 130 milionami synaps i funkcjonujących w czasie rzeczywistym. Procesor składa się z 128 rdzeni neuromorficznych, zdolnych do uczenia się oraz wnioskowania logicznego, a także obsługuje hierarchiczny protokół sieciowy, co zapewnia wydajną komunikację między rdzeniami. Loihi był pierwszym w pełni zintegrowanym układem sieci neuronowej, który umożliwiał kompresję rzadkich sieci, multiemisję między rdzeniami, obsługę różnych formatów synaps oraz hierarchiczną łączność.

W drugiej połowie 2021 roku Intel wprowadził zaktualizowaną wersję, procesor Loihi 2, w którym liczba modelowanych neuronów wzrosła z 128 000 do 1 miliona. Loihi 2 ma również udoskonalone możliwości programowania modeli neuronowych, co pozwala na bardziej elastyczne podejścia do modelowania.

Charakterystyka porównawcza kluczowych cech procesorów neuromorficznych oraz wczesnych systemów neuromorficznych

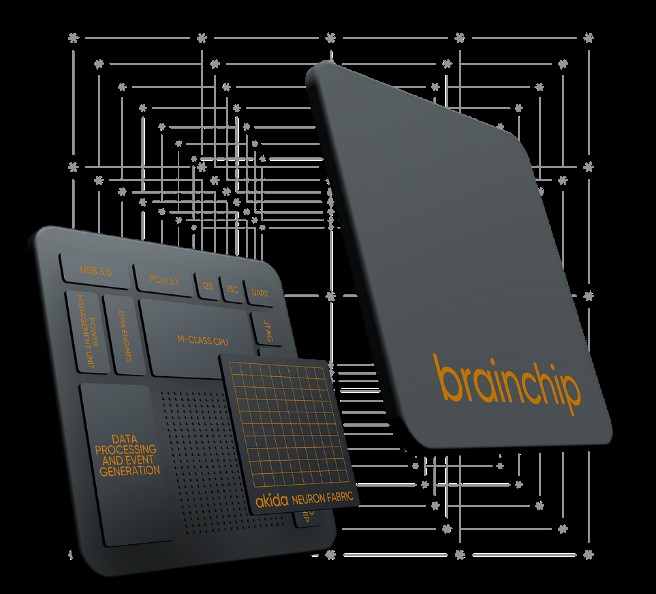

Wszystkie wymienione powyżej procesory neuromorficzne nie są dostępne do indywidualnego zakupu. W styczniu 2022 roku firma BrainChip ogłosiła wprowadzenie na rynek procesora sieci neuronowej Akida, który, według twórców, jest pierwszym komercyjnie dostępnym procesorem neuromorficznym. Produkt ten ma zapewniać wyjątkowo niskie zużycie energii przy jednoczesnej wysokiej wydajności, co stanowi znaczące ulepszenie w porównaniu do tradycyjnych rozwiązań.

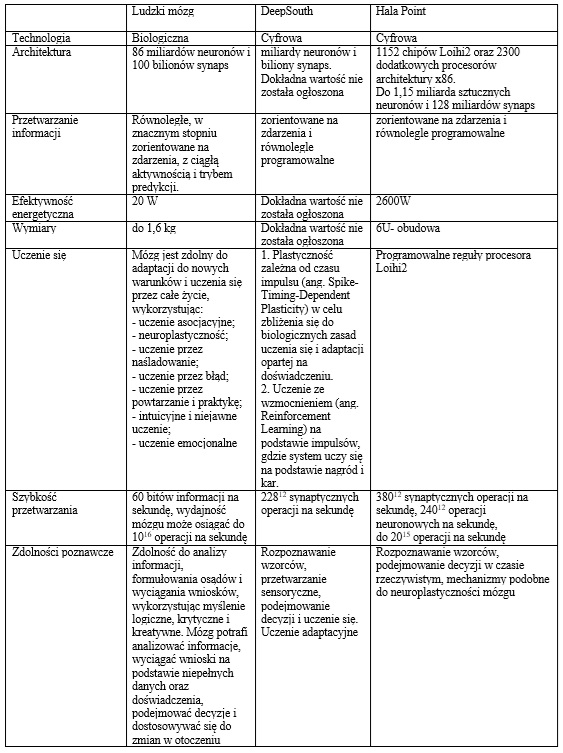

Od 2020 roku, opierając się na postępach w dziedzinie procesorów neuromorficznych, naukowcy rozpoczęli rozwój potężnych superkomputerów neuromorficznych. W grudniu 2023 roku australijscy badacze z Uniwersytetu Zachodniego Sydney poinformowali o stworzeniu pierwszego na świecie superkomputera opartego na procesorzach neuromorficznych, zdolnego do wykonywania około 228 bilionów operacji synaptycznych na sekundę, co jest porównywalne z aktywnością ludzkiego mózgu. Ten neuromorficzny system, nazwany DeepSouth, został zaprojektowany do przetwarzania ogromnych ilości danych z dużą prędkością, przy znacznie niższym zużyciu energii w porównaniu z tradycyjnymi superkomputerami. Profesor André van Schaik, jeden z autorów badania, stwierdził: «Platforma DeepSouth poprawi nasze zrozumienie struktury ludzkiego mózgu oraz przyczyni się do opracowania systemów obliczeniowych nowej generacji dla różnych dziedzin, takich jak zastosowania sensoryczne, biomedycyna, robotyka, kosmos i sztuczna inteligencja na dużą skalę.»

W 2024 roku firma Intel ogłosiła stworzenie największej na świecie neuromorficznej systemu obliczeniowego o nazwie Hala Point. System, zainstalowany w Sandia National Laboratories w Nowym Meksyku w USA, został zaprojektowany w celu naśladowania mechanizmów przetwarzania informacji charakterystycznych dla ludzkiego mózgu. Hala Point składa się z 1152 chipów Loihi 2, obsługujących do 1,15 miliarda sztucznych neuronów i 128 miliardów synaps, co odpowiada mocy mózgu małej małpy lub sowy.

Główną zaletą systemu jest jego wysoka wydajność energetyczna: Hala Point zużywa minimalną ilość energii w trybie czuwania, podczas gdy tradycyjne procesory graficzne wymagają znacznych zasobów nawet w stanie bezczynności. System jest w stanie przetwarzać dane 50 razy szybciej i zużywa 100 razy mniej energii niż tradycyjne platformy obliczeniowe

W niedalekiej przyszłości naukowcy z Sandia National Laboratories planują wykorzystać Hala Point do rozwiązywania złożonych problemów naukowych w takich dziedzinach, jak fizyka materiałów, architektura komputerowa, modelowanie oraz badania nad sztuczną inteligencją. Chociaż Hala Point znajduje się w początkowej fazie działania i nie jest dostępny jako produkt komercyjny, naukowcy będą mogli go wykorzystać do zaawansowanych badań w dziedzinie obliczeń neuromorficznych.

2. Alternatywna architektura: jak działa procesor neuromorficzny?

Procesor neuromorficzny to specjalny typ procesora, którego architektura jest maksymalnie zbliżona do struktury biologicznych sieci neuronowych, zaprojektowany w celu optymalizacji obliczeń pulsujących sieci neuronowych. Tradycyjne komputery przetwarzają informacje w sposób liniowy, realizując polecenia pojedynczo przy użyciu procesorów centralnych (CPU) i graficznych (GPU). Architektura procesorów neuromorficznych różni się radykalnie od architektury tradycyjnych procesorów. Nie dążą one do wykonywania operacji arytmetycznych w sposób sekwencyjny ani równoległy. Zamiast tego, naukowcy starają się odtworzyć strukturę oraz zasady działania ludzkiego mózgu. Procesory neuromorficzne naśladują ludzki mózg, dzieląc złożone zadania obliczeniowe na prostsze operacje, które są następnie równoległe i przetwarzane jednocześnie.Głównym celem rozwoju architektury procesora neuromorficznego jest osiągnięcie zdolności do równoległego przetwarzania informacji przy zużyciu energii ograniczonym do kilkudziesięciu watów. W tym celu integrowane są bloki pamięci oraz przetwarzania (ang. in-memory computing).

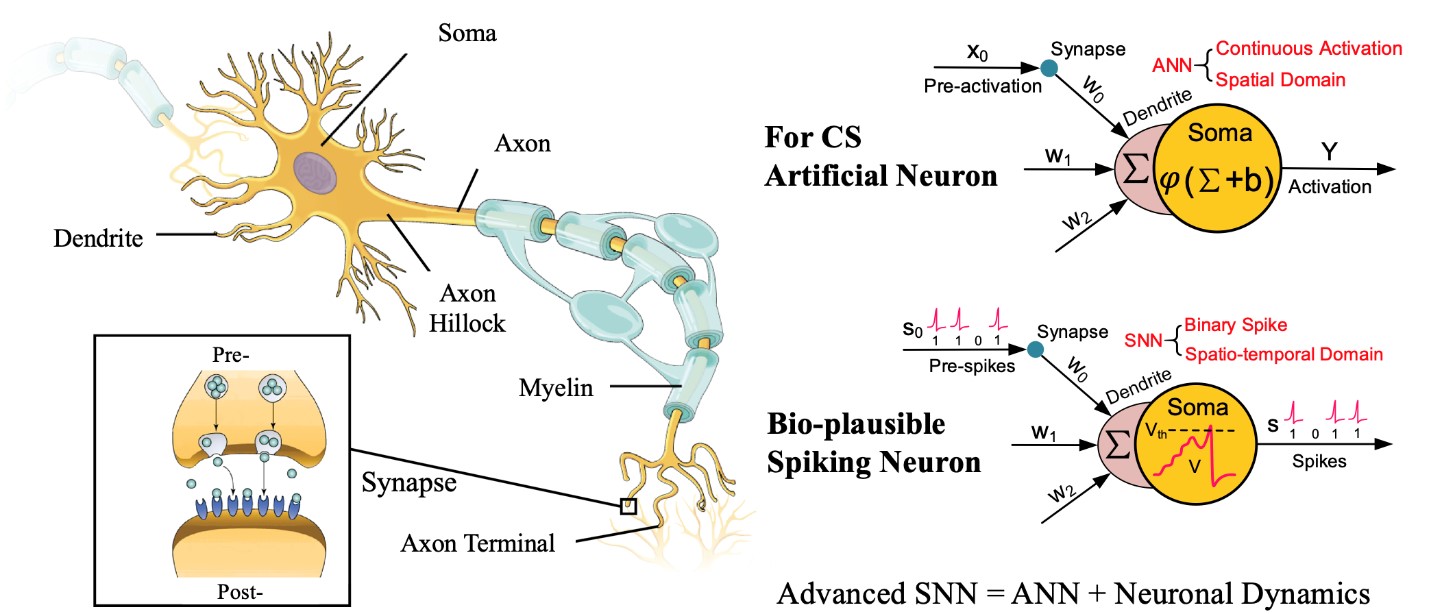

Zamiast tranzystorów kontrolujących przepływ elektronów, procesor neuromorficzny wykorzystuje sztuczne neurony i synapsy. Sztuczne neurony oraz synapsy realizują obliczenia, naśladując sposób, w jaki sygnały są przesyłane pomiędzy neuronami w biologicznym mózgu. Neurony odbierają sygnały, przetwarzają je, a następnie przekazują dalej poprzez synapsy. Sygnały te są aktywowane po osiągnięciu określonego progu, co jest analogiczne do impulsów elektrycznych (ang. spike) w systemach biologicznych. Takie podejście umożliwia równoległe przetwarzanie danych, tak jak robi to mózg.

Architektura procesorów neuromorficznych

Sygnały przekazywane przez synapsy mają postać wartości numerycznych lub «wag», a procesor neuromorficzny wykorzystuje te wagi do rozkładu obciążenia między wieloma równoległymi rdzeniami. Im większa waga synapsy, tym silniejszy wpływ odpowiedniego neuronu na ogólny wynik obliczeń.

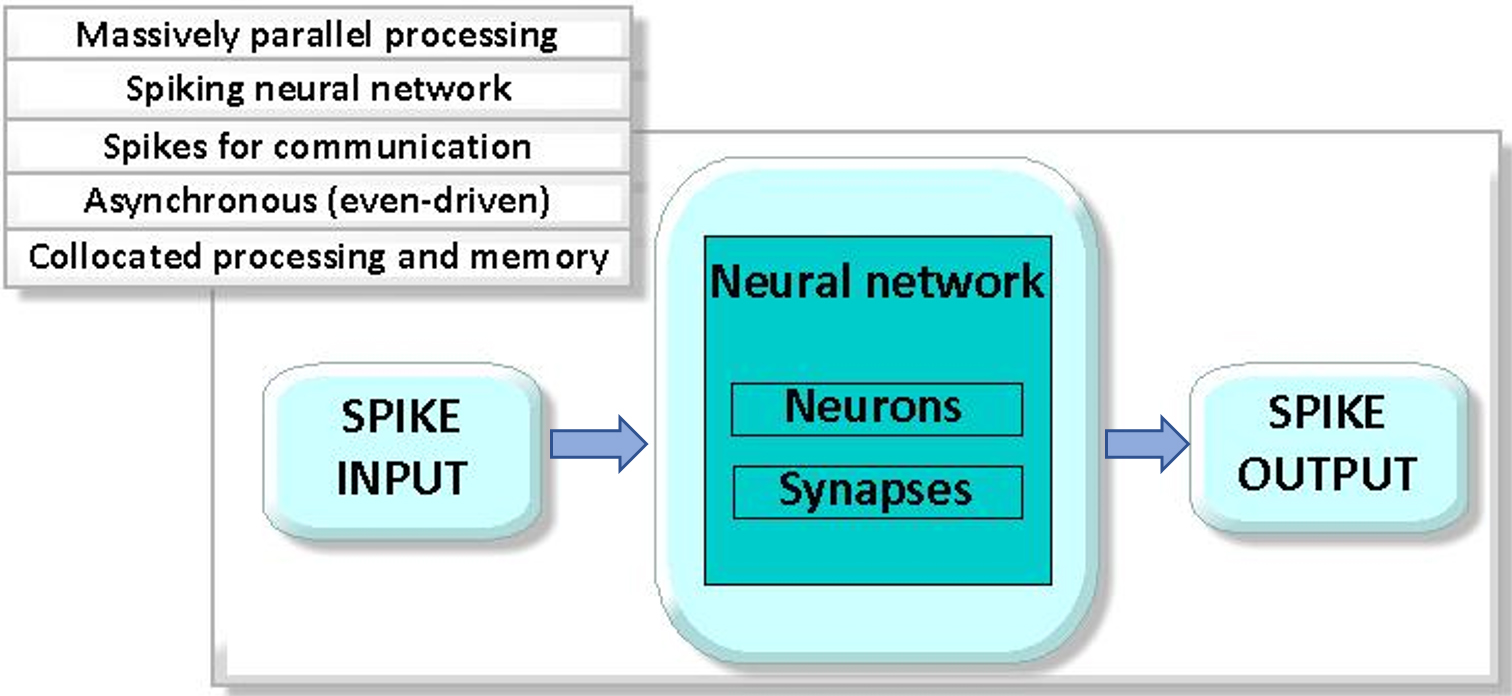

Procesory neuromorficzne wykorzystują pulsujące sieci neuronowe (ang. Spiking Neural Networks, SNN) do symulowania aktywności mózgu na poziomie biologicznie bardziej realistycznym niż tradycyjne sztuczne sieci neuronowe. Główna różnica między SNN a konwencjonalnymi sieciami neuronowymi polega na tym, że w SNN informacje nie są przekazywane jako ciągłe sygnały, lecz jako pojedyncze zdarzenia lub impulsy aktywności.

3. Pulsujące (impulsowe) sieci neuronowe – podstawa procesora neuromorficznego

Pulsujące sieci neuronowe (Spiking Neural Networks, SNN) stanowią podstawę neuromorficznych procesorów. SNN, które pojawiły się pod koniec lat 90., reprezentują trzecie pokolenie sztucznych sieci neuronowych. W odróżnieniu od sieci neuronowych pierwszej i drugiej generacji, w sieciach pulsujących neurony komunikują się za pomocą dyskretnych impulsów o stałej amplitudzie. Impuls jest generowany tylko wtedy, gdy neuron zgromadzi wystarczającą ilość danych, aby przekroczyć wewnętrzny próg aktywacji, co pozwala na oszczędność energii. Takie struktury neuronowe charakteryzują się wysoką równoległością w rozprzestrzenianiu impulsów. Wejściem i wyjściem w pulsujących sieciach neuronowych są sekwencje czasowe dyskretnych zdarzeń – tzw. kolców (ang. spikes), a nie wektory wartości numerycznych. Reprezentacja danych w postaci zdarzeń umożliwia asynchroniczne przetwarzanie informacji, angażując jedynie te fragmenty sieci, które bezpośrednio uczestniczą w przetwarzaniu danego zdarzenia.

Teoretycznie, pulsujące sieci neuronowe (SNN) zużywają mniej energii i działają szybciej niż sztuczne sieci neuronowe drugiej generacji. SNN oferują kilka kluczowych zalet w porównaniu z sieciami neuronowymi pierwszej i drugiej generacji:

– Efektywne modelowanie danych o charakterze czasowym, czasowo-przestrzennym lub spektralnoczasowym;

– Precyzyjne odwzorowanie procesów w różnych skalach czasowych;

– Integracja wielu modalności, takich jak dźwięk i obraz, w ramach jednego systemu;

– Szybkie i masowo równoległe przetwarzanie informacji;

– Kompaktowe przetwarzanie informacji;

– Skalowalne struktury (od kilkudziesięciu do miliardów neuronów);

– Niskie zużycie energii

4. Ludzki mózg a system obliczeniowy neuromorficzny

Stworzenie sztucznego mózgu stanowi jedno z najtrudniejszych wyzwań współczesnej nauki, a procesory neuromorficzne reprezentują istotny krok naprzód w tej dziedzinie. Twórcy systemów neuromorficznych wskazują, że ich wydajność znacznie przewyższa tradycyjne systemy sztucznej inteligencji oparte na architekturach CPU i GPU. Jednocześnie pojawia się pytanie, w jakim stopniu procesory neuromorficzne mogą przybliżyć się do funkcjonalności ludzkiego mózgu. Analiza porównawcza tradycyjnych procesorów, procesorów neuromorficznych i ludzkiego mózgu pozwala wyróżnić następujące kluczowe aspekty ich działania:

- Integracja pamięci i jednostek obliczeniowych: W tradycyjnych komputerach dane muszą być przesyłane pomiędzy pamięcią a procesorem w celu przeprowadzenia obliczeń, co powoduje występowanie wąskich gardeł i zwiększa opóźnienia. Procesory neuromorficzne integrują pamięć i jednostki obliczeniowe, co minimalizuje opóźnienia i znacząco redukuje zużycie energii.

- Asynchroniczność: W odróżnieniu od tradycyjnych procesorów, które działają na stałej częstotliwości zegara, procesory neuromorficzne pracują asynchronicznie, aktywując się wyłącznie w momencie konieczności przetworzenia danych, naśladując działanie ludzkiego mózgu. To podejście umożliwia znaczną oszczędność energii.

- Modelowanie zdarzeniowe: Procesory neuromorficzne przetwarzają dane na podstawie modelu zdarzeniowego, aktywując się wyłącznie w odpowiedzi na określone wydarzenie. Jest to analogiczne do działania neuronów w ludzkim mózgu, które „aktywują się” tylko po osiągnięciu pewnego progu sygnału. W mózgu człowieka neurony komunikują się przez synapsy, przekazując sygnały chemiczne i elektryczne, co umożliwia integrację i przetwarzanie informacji w sposób złożony i efektywny.

- Przetwarzanie równoległe: Podobnie jak ludzki mózg, procesory neuromorficzne są zoptymalizowane do masowo równoległego przetwarzania danych, co pozwala na jednoczesne przetwarzanie ogromnych ilości informacji. To sprawia, że są one szczególnie efektywne w zadaniach takich jak rozpoznawanie obrazów czy dźwięków. Dzięki złożonej strukturze i podziale funkcji między różne obszary, ludzki mózg jest zdolny do jednoczesnego przetwarzania licznych bodźców sensorycznych.”

- Plastyczność: Niektóre systemy neuromorficzne mają zdolność uczenia się i adaptacji poprzez zmianę połączeń między neuronami, co jest podobne do plastyczności synaptycznej w biologicznym mózgu. Plastyczność ta pozwala mózgowi dostosowywać się do nowych środowisk, uczyć się na podstawie doświadczeń i przywracać funkcje po urazach.

Charakterystyka porównawcza ludzkiego mózgu i najnowszych systemów neuromorficznych DeepSouth i Hala Point

Porównując wydajność systemów neuromorficznych DeepSouth i Hala Point, można zauważyć, że ich twórcy zbliżyli się do prędkości przetwarzania informacji porównywalnej z ludzkim mózgiem. Niemniej jednak zdolności poznawcze tych systemów, nawet najbardziej zaawansowanych, wciąż znacząco ustępują możliwościom ludzkiego mózgu. Systemy neuromorficzne nie osiągnęły jeszcze poziomu adaptacyjności, elastyczności ani neuroplastyczności charakterystycznych dla ludzkiego mózgu.

Podsumowując:

Systemy neuromorficzne, których architektura możliwie najbliżej odwzorowuje strukturę biologicznych sieci neuronowych, dynamicznie rozwijają się na całym świecie i stają się jednym z kluczowych kierunków badań w sztucznej inteligencji. Najwyższym celem tych dążeń jest stworzenie zaawansowanej sztucznej inteligencji – maszyny, która nie tylko rozwiązuje konkretne problemy, ale także wyznacza nowe cele badawcze. Warto zauważyć, że neuroprocesory już teraz zyskują popularność, ponieważ teoretycznie umożliwiają bardziej efektywne rozwiązanie istniejących problemów.

Systemy neuromorficzne osiągają doskonałe wyniki w wyspecjalizowanych zadaniach sztucznej inteligencji, takich jak rozpoznawanie wzorców, przetwarzanie danych sensorycznych, zadania związane z autonomiczną jazdą oraz analiza dźwięku i obrazu. Jednak, w obszarach wymagających myślenia abstrakcyjnego i złożonej analizy, systemy te nie mogą jeszcze konkurować z ludzkim mózgiem. Ludzki mózg, dzięki współdziałaniu zdolności poznawczych, jest zdolny do złożonego przetwarzania informacji, rozwiązywania problemów i adaptacji do nowych sytuacji.

Odpowiadając na pytanie, czy procesory neuromorficzne odwzorują potencjał ludzkiego mózgu, można stwierdzić, że pod względem szybkości przetwarzania informacji są one w stanie nie tylko zbliżyć się do wydajności ludzkiego mózgu, ale także ją przewyższyć. Jeśli chodzi o zdolności poznawcze, na obecnym poziomie rozwoju nauki i technologii systemy neuromorficzne nie są w stanie konkurować z ludzkim mózgiem, ponieważ ludzki mózg pozostaje bezkonkurencyjny w zakresie zdolności do nauki, uogólniania wiedzy oraz przeprowadzania złożonych operacji logicznych w różnych dziedzinach. Co więcej, potencjał i biochemia ludzkiego mózgu wciąż skrywają ogromną liczbę nieodkrytych tajemnic, co stanowi wyzwanie dla dalszego rozwoju inżynierii neuromorficznej. Jej przyszły rozwój w dużej mierze zależy od postępów w badaniach nad mechanizmami funkcjonowania mózgu. Kluczowe pytania, takie jak: skąd pochodzą funkcje poznawcze, jakie mechanizmy molekularne i komórkowe prowadzą do długoterminowych zmian behawioralnych oraz jak neurony w różnych obszarach mózgu synchronizują się i działają asynchronicznie, tworząc spójny obraz percepcji i świadomości, mogą stanowić podstawę do opracowania sztucznej inteligencji naśladującej ludzkie zdolności poznawcze.